12月1日绵阳启动天气黄色预警防护措施

2023-12-02

更新时间:2023-11-29 14:28:25作者:橙橘网

随手用鼠标一涂,图片里的东西就跟着动起来。

这种堪称马良神笔的操作,真实地在我们的生活中发生了。。。

而这一切,都是通过一家名叫 Runway 的视频制作网站完成的。

如果有熟悉这家公司的朋友就会知道,他家之前还给电影《 瞬息全宇宙 》做过特效。

今年年初,他们也靠着文生视频的功能,在 AI 圈打出了名声。

而这次更新, Runway 则又推出了一个名叫Motion Brush ( 运动画笔 )的 “ 王炸 ” 功能,只要涂一涂,图片秒变视频,算是刷新了世超对于 AI 生成视频工具的认知。

从 Demo 的效果来看,跟耗资上百万美刀的动画制作相比,虽然不能说一模一样,但也有个七八分像了。

反正我看完,是再一次被 AI 的进化速度给震惊到了,照这么发展下去,以后拍电影拍动画哪还用得着人啊?

但 Demo ,往往都要比咱们上手试出来的效果要好很多。

所以,为了看看这个运动画笔到底咋回事儿,还是老样子,世超先替你们测评一波。

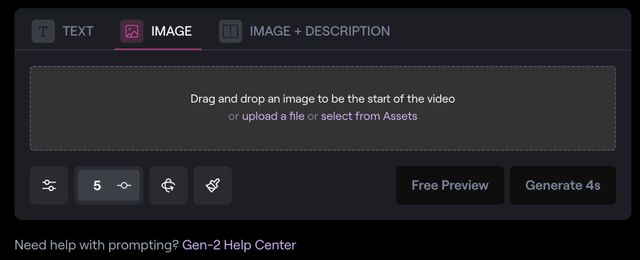

从官网打开 Gen-2 ,页面是这样儿的。

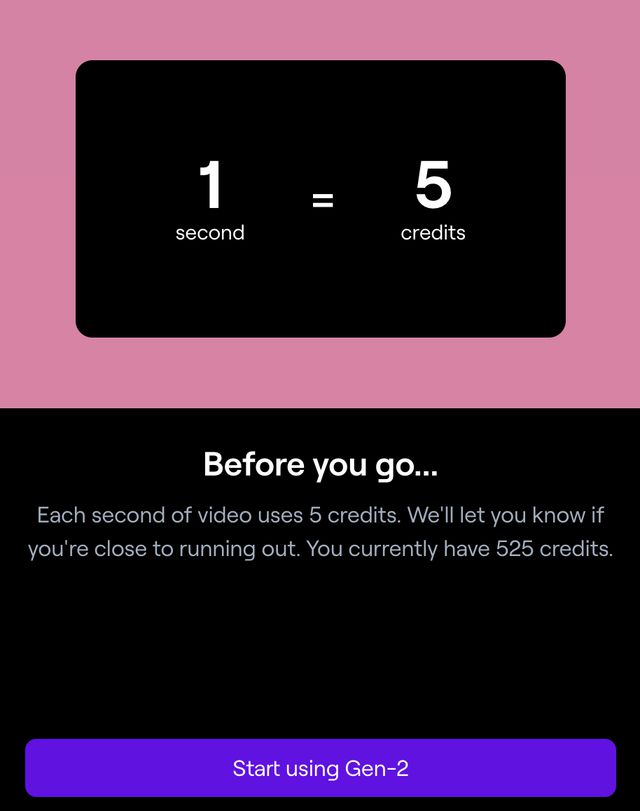

不过,生成视频并不全是免费的,在开始之前官方会弹出一个说明,一共 525 个积分, 1s 算 5 个积分,按照一个视频 4s 来算,咱们能白嫖到 26 个。

接下来,咱们像这样先上传一张照片,或者也可以用图片 + 文字描述结合的方法。

下面,就有一个 “ Motion Brush ” 的 BETA 版按钮。

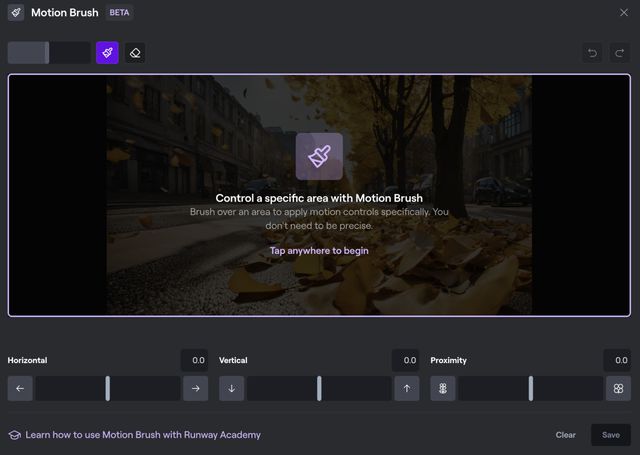

点进去,左上角可以调整画笔和橡皮擦的大小,下面的三个参数值分别代表向左向右、向上向下以及离镜头的距离远近。

这里可能得注意一下,不是只要用画笔涂了就万事大吉,参数的调整也同样很重要。

不然,你可能会得到一个像这样奇奇怪怪的视频。。。

一开始的失败作品

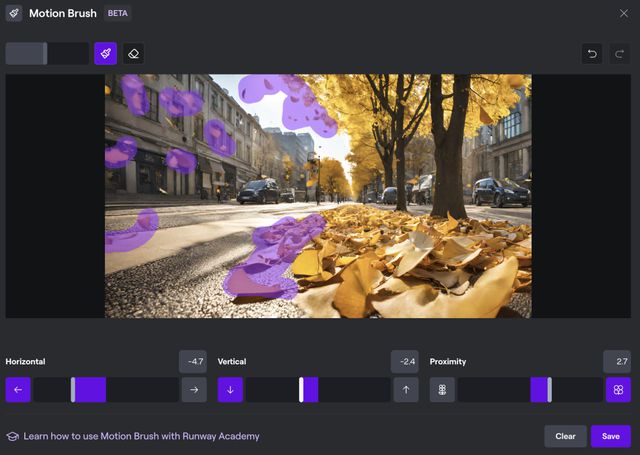

像这张图,我想要呈现出来的是银杏叶子随风飘落的画面,用画笔把一些叶子涂抹之后,再把吹落的方向往左下方调一调。

参数调完,点击生成等个 1 分钟差不多就好了。

看看这效果,我只想说:妈妈,我要去拍电影!

说真的,我觉得这次 Runway 的更新有点过于强悍了。。。

包括头发还有海浪,效果也都不错,重点在于,整个过程操作下来不过 2-3 分钟,新手完全无压力。

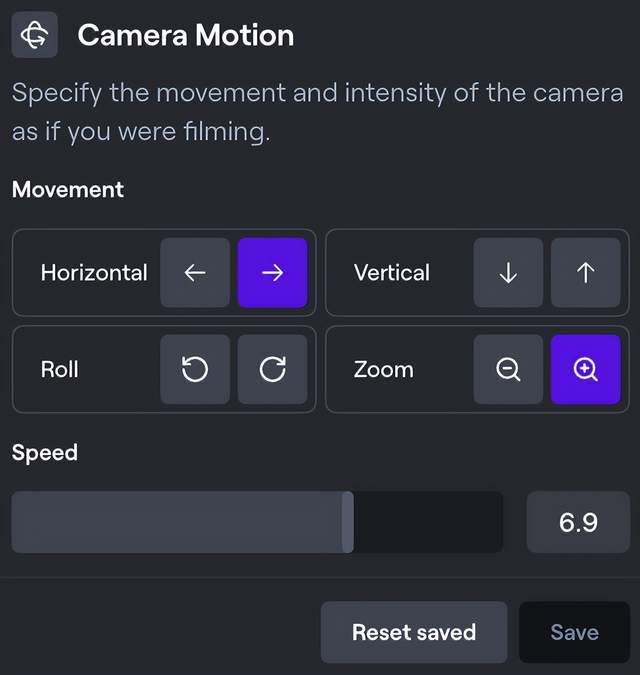

如果想调整相机的角度,运动画笔旁边还有个 Camera Motion ,可以控制镜头的移动、变焦等等,就跟拍电影似的。

比如这个视频,我设置相机的镜头往右移,生成出来的东西我叫它《 梵高爆改贝克汉姆 》。

虽然生成出来的东西,似乎已经跟梵高没啥关系了,但从面部轮廓、光线的变化来看,效果还是不错的。

还有这个老马烤肉,很多细节上看着很奇怪,但到这为止,其实都还算是正常的。

但是用着用着,我发现 Gen-2 的生成主打的就是一个看心情。

这张经典的 meme 图,大伙儿应该都眼熟吧?

我本来是打算借着 Gen-2 给这位老哥来一个 “ 华丽 ” 的转身,但没想到,全都乱了套了。

衬衫小伙儿变 POLO 衫大叔、女人的白眼、女朋友当街变装,要素太多,甚至不知道该从哪里开始吐槽。。。

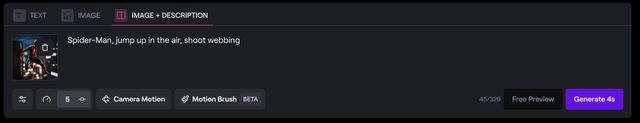

接着,我又用另外一张蜘蛛侠的图片试了试,这次想要的效果是蜘蛛侠在空中飞起来。

为了防止出岔子,我还多加了一句文字描述。

结果,还是翻车了。

移动效果是有的,只不过这个蜘蛛侠后面已经完全变形了。

而且翻车的还不止这一个,像这张图生成出来的东西,更是重量级。

想象中:海浪拍打着沙滩,海风吹着女孩的头发和裙子,女孩转身往另一边。

现实里:鬼啊!!

这 AI ,是直接把人当烟给飘走了。。。

试用下来,我觉着这个运动画笔在处理一些简单的自然风景上还是不赖的,但图片要素一多,就容易在细节上出问题。

从一个刚刚上手的新人角度来说,想要把 Gen-2 调教好可能还需要一些门槛。

世超在这里给个小建议,如果想要生成视频的效果不那么离谱,除了用画笔涂、调整参数以外,最好还是用文字再描述一遍。

还有大伙儿应该也能看出来, Gen-2 生成出来的视频速度是很慢的,流畅度也没那么丝滑。

总的来说,好坏参半吧。

不过,从年初开始,像 Gen-2 这类的 AI 生成视频工具,其实已经进化得很快了。

今年 8 月,有位老哥还用 Runway 手搓出了一部《 流浪地球 3 》的预告片。

包括 Stability AI ,最近也发布了开源 AI 视频模型 Stable Video Diffusion 。

咱们看待技术发展的眼光,或许可以宽容些。

毕竟, AI 绘画刚出来的时候,在生成结果的稳定性、可控性还有细节描述能力上,也闹过不少笑话。

从文生视频到图生视频,从单一模态到多模态,现在的 AI 生成视频有点在爆发前夜的感觉。

去年差不多也是这个时候, Stable Diffusion 、 Midjourney 等一众 AI 绘画工具爆火,都说人间一天, AI 一年,明年说不定就轮到视频了。