思聪与自如

2023-12-02

更新时间:2023-11-09 22:05:26作者:橙橘网

《科创板日报》9日讯,记者从产业链人士处了解到,英伟达现已开发出针对中国区的最新改良版系列芯片:HGX H20、L20 PCle和L2 PCle。知情人士称,最新三款芯片是由H100改良而来,英伟达最快或将于本月16号之后公布,国内厂商最快将在这几天拿到产品。记者向英伟达求证了该消息的真实性,但截至发稿,英伟达方面暂无回应。(蓝鲸记者 张洋洋)

延伸阅读:

AMD MI300绝杀英伟达H100?跑GPT-4性能超25%,AI芯片大决战一触即发

新智元报道

编辑:好困Aeneas

【新智元导读】面对即将到来的AI芯片大决战,不少芯片初创公司跃跃欲试,希望一举打破英伟达的垄断地位。而AMD的MI300,在部署32K上下文窗口的GPT-4模型时,居然比H100效果更好?

AI芯片大决战,即将来临!

AI硬件开发商初创公司的未来会怎样?

Tenstorrent CEO David Bennett直言不讳地表示,在我们这个行业,大部分初创公司的结局就是倒闭。

该如何生存?他建议初创企业应该保持灵活性,避免将自己局限在狭隘的用例中。

这里,Bennett指的并不是某个小众市场, 而是由SiMa.ai到Cerebras等数十家公司组成的一个广泛集团。他们共同筹集了数十亿美元的风投,来对抗这个市场的领导者——英伟达。

Bennett深谙此道。他曾在AMD从事销售工作十多年。

而他目前的雇主Tenstorrent的CEO,是Jim Keller,一位硬件传奇人物。他曾开发出支持iPhone 4和iPad 2的苹果A4和A5处理器,并在2016年至2018年负责特斯拉自动驾驶汽车的硬件工作。

Tenstorrent公司已经从富达风投和现代汽车等投资者筹集了超过3亿美元的资金,它遵循了Bennett的建议:从芯片到云计算等,提供一切服务。

Bennett表示,如今的芯片初创公司,大致都是在「为AI制造专用硬件」和「依赖当下流行模式」这两者之间徘徊。

英伟达的劣势:很难从头制造芯片

英伟达的AI芯片GPU起家的故事,实际上为今天的芯片初创公司提供了优势。

图形处理单元起初是为计算机图形学提供动力的,但由于它能并行执行多种计算,才在AI应用领域大放异彩。

不过,但这一意外也给英伟达带来了不利因素——现在,英伟达很难在不影响现有GPU业务的情况下,从头开始制造芯片了,而这,就给了新兴初创公司提供了机会,制造专为AI打造的新硬件。

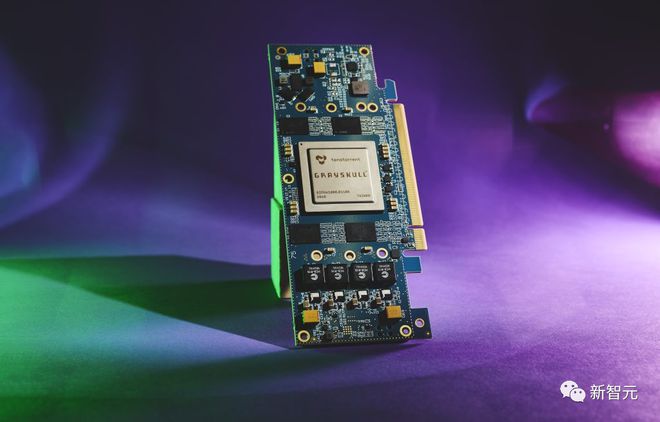

比如,Tenstorrent的工程师就为未来的稀疏神经网络设计了Grayskull芯片,在这种网络中,冗余信息可以被去除。

尽管如此,Bennett认为,专注于为大语言模型构建芯片的初创公司,和Transformer架构捆绑得太紧了。

在这种架构下,基于Transformer的模型基本是在预测最有可能出现的下一个单词,因此它们一直被诟病生成的回答是基于概率,而非基于推理。

这也就意味着,在当前的AI热潮中,这些模型架构可能无法幸存下来。

毕竟,由于发展速度太快,如今的LLM寿命相对较短。昨天还炙手可热的模型,一两周后可能就会销声匿迹。

另一个对硬件公司来说风险很大的领域,就是制造专门用于推理的芯片。

这方面的代表是芯片开发商d-Matrix,它计划在明年上半年发布推理专用芯片。

乍一看,这个策略似乎不错。生成式AI应用的用户现在会越来越多地利用现有的专有或开源模型,而不是从头开始构建自己的模型。

正因如此,许多人认为,应该在模型推理上花更多钱,而非模型训练上。

虽然从商业角度来看,这可能是一个明智之举,但Bennett认为,过于狭隘地专注于推理,会阻碍硬件开发人员为其他可能更受欢迎的用例提供服务。

例如,对于运行模型所需的低精度计算,纯推理芯片就够了。

但是,如果开发者想要微调大模型,就很可能需要能处理更高精度计算的芯片了。

尖端芯片,把GPU和CPU放在一起

为了在即将到来的AI芯片大决战中幸存,芯片开发商需要改变芯片的架构。

今天,大多数芯片都是把GPU和CPU分开的。前者能够同时执行多种计算,后者负责执行更多的通用指令,管理更广泛的系统操作。

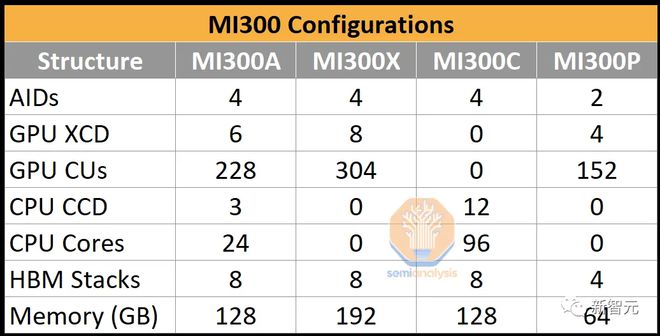

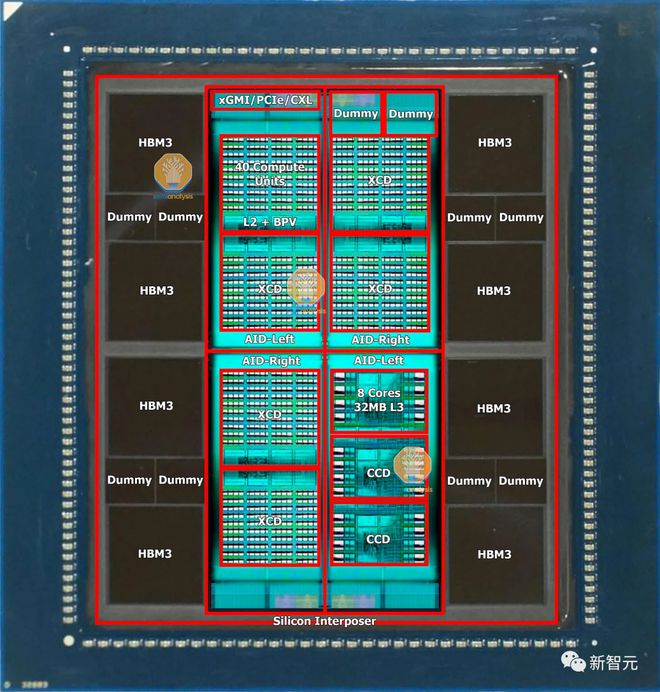

然而越来越多的尖端芯片(如英伟达的Grace Hopper超级芯片和AMD即将推出的MI300A),都将GPU和CPU放在一起。

这种布局可以让CPU更快地准备数据,将数据加载到GPU上,从而加快模型的训练。

另外,硬件初创公司想要打破英伟达的市场主导地位,还面临着一个最大的障碍,就是软件优势。

英伟达用于编写机器学习应用程序的Cuda软件,只能在自家芯片上运行。而这实际上就把开发者锁定在了英伟达GPU上。

AMD MI300跑GPT-4更6

英伟达的霸主地位,就这么难以撼动?

Semianalysis记者Dylan Patel和Myron Xie最近就发文称,AMD的MI300在性价比方面,将会明显优于英伟达的H100!

他们表示,随着新一代MI300的推出,AMD即将成为英伟达和谷歌在LLM推理领域唯一的竞争对手。

相比之下,Groq、SambaNova、英特尔、亚马逊、微软等公司仍无法与之抗衡。

此外,为了应对英伟达基于CUDA构建的护城河,AMD一直在大力投资自己的RoCM软件、PyTorch生态系统和OpenAI的Triton。

随着Databricks、AI21、Lamini、Moreph等公司开始使用AMD GPU进行推理/训练,AMD自己的生态也愈发完善。

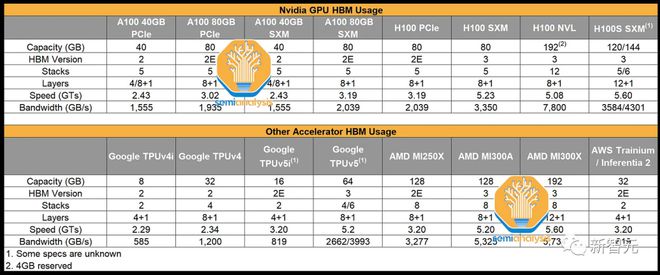

据业内人士透露,拥有更大显存的MI300,在部署32K上下文窗口的GPT-4模型时效果更好。

具体来说,与H100相比,MI300的性能优势在20%到25%之间,具体取决于上下文长度和提示长度/每次查询输出的token数量。

再加上更低廉的价格,MI300在性价比方面,将会明显优于英伟达的H100,甚至是H200。

大厂纷纷下单

目前,微软、Meta、甲骨文、谷歌、Supermicro/Quantadirect、亚马逊等公司已经向AMD下了大约205,000台MI300的订单。

在这之中,有120,000台专门供应给微软,25,000台给Meta,12,000台给甲骨文,8,000台给谷歌,5,000台给亚马逊公司,35,000台给其他公司。

而且由于数量巨大,微软购买MI300的价格预计要比其他客户低上不少。

为了计算MI300在明年为AMD带来的收入,需要从两个角度进行分析:AMD能确保多少供应量,以及主要客户会订购多少。

在供应方面,MI300的产能将在年内逐步提升,但由于英伟达B100会在第二季度开始出货,并在第三季度随着性价比更高的风冷版的推出而大幅提升,这将在很大程度上影响AMD在第四季度的出货量。

同时,还需要考虑内存制造商的HBM产量、CoWoS产量、封装产量以及使用CoWoS生产的每种加速器的情况,包括英伟达、AMD、Google/Broadcom、Meta/Broadcom、Intel/Al Chip、Amazon/Al Chip、Amazon/Marvell、Microsoft/GUC等。

即便如此,业内依然认为MI300X第四季度的出货量可以达到110,000台。

客户方面,微软、Meta、甲骨文、谷歌、Supermicro/Quantadirect和亚马逊是订单的主要来源,但也有一些订单来自供应链的其他部分,包括一些用于HPC型应用的MI300A。

利润方面,英伟达并没有降价的迹象,只是在价格不变的情况下增加了HBM容量/带宽。而与英伟达超过80%的利润率相比,AMD在MI300上的利润率仅勉强超过了50%。

AMD首席执行官苏姿丰表示,基于公司在AI方面的快速进展以及云计算客户的购买承诺,数据中心GPU的收入预计将在第四季度达到4亿美元,2024年将超过20亿美元。

这一增长也将使MI300成为AMD历史上销售额最快达到10亿美元的产品。

对此,业内对于MI300X的销售额则更加乐观——预期可以达到35亿美元。

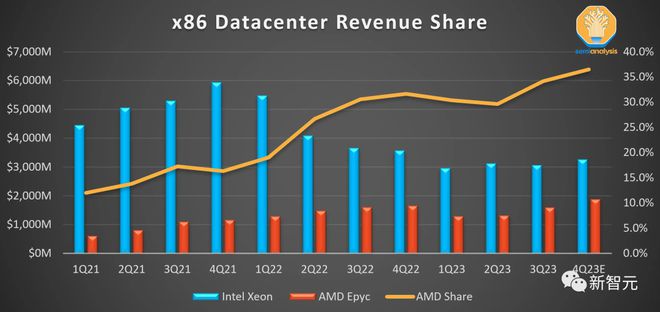

从AMD目前在LLM训练和推理领域小于0.1%的市场份额来看,AMD在数据中心领域的市场份额依然会稳步增长。

参考资料:

https://www.theinformation.com/articles/an-ai-chip-armageddon-is-coming-biden-punts-on-open-source-llms?rc=epv9gi

https://www.semianalysis.com/p/amd-mi300-ramp-gpt-4-performance